Lenovo Storage (ex-Storwize) V3700 V2 XP для чайников

Моя попытка знакомства с компанией Lenovo началась ещё в 2014 году, тогда мне очень хотелось взять какой-нибудь сервер из линейки компании для обзора. Лично мне эти серверы были крайне интересны ввиду того, что в нашей стране они (по крайней мере пока) встречаются крайне редко. Но тогда не сраслось. И так, осенью этого года мне предложили для обзора СХД Lenovo V3700 V2, но и тут всё вышло не так быстро, как мне бы того хотелось и в итоге массив ехал до меня около 2 месяцев. Конечно по сравнению с более известными и популярными интернет и печатными изданиями я нахожусь в более низком приоритете у вендора, так что массив приехал ко мне последнему, когда все уже кто хотел его потестировали и написали свои обзоры.

Большой обзор написал thg.ru, а очень приятный видео-обзор снял IXBT.com.

Передо мной встал вопрос — а что же буду писать я? Делать миллионный тест массива — не интересно, да и моя домашняя инфраструктура не готова к таким нагрузкам, т.к. моя тестовая песочница живёт всего-лишь на 4Gb SAN. По этому было принято решение больше рассказать о том, что это за массив, с чего всё начиналось и что он умеет.

Думаю я не открою большого серкрета, ведь многие это знают и так, компания Lenovo приобрела данную линейку массивов у компании IBM, как это произошло чуть ранее с серверным направлением. И это ни что иное, как обновлённый массив IBM Storwize V3700. Младшая модель этой линейки. У меня на тесте побывала её «прокачанная» версия XP. Массивы IBM Storwize трансформировались в линейку Lenovo Storage. Так что полное название массива — Lenovo Storage V3700 V2 XP. XP говорит о том, что это версия с более мощным контроллером, который позволяет расширять кэш до 16Gb.

Родоначальником этой линейки стал массив V7000 ещё в 2010-м году, так что эта платформа успела уже переболеть всеми детскими болезни, присущими новым продуктам.

Технические характеристики V3700 V2 XP

Форм-фактор СХД и полок расширения: 2U, 24 диска SFF (2,5″) или 12 дисков LFF (3,5″)

Максимальное количество дисков: 240 SFF или 120 LFF (9 полок расширения, не совместим с полками расширения первого поколения)

Максимальный объём дискового пространства: 960 ТБ

Интерфейс подключения дисков и полок расширения: SAS 3.0

Число контроллеров: 2

Режим работы контроллеров: ALUA

Отказоустойчивость:

- Защита содержимого кэш-памяти при аварийном отключении питания (аккумулятор)

- Зеркалирование содержимого кэш-памяти между контроллерами

Поддержка RAID: 0, 1, 5, 6, 10; распределённый RAID (DRAID) 5 и 6

Объём памяти (на каждый контроллер): 8 ГБ, поддерживает расширение до 16 ГБ

Стандартные порты для подключения хостов (на каждый контроллер):

- 2x 1 Гбит iSCSI (RJ-45)

- 2x SAS 3.0 (SFF-8644, mini-SAS HD x4)

Опциональные порты для подключения хостов (на каждый контроллер, в зависимости от установленной интерфейсной платы):

- 4x SAS 3.0 (SFF-8644, mini-SAS HD x4)

- 4x 1 Гбит iSCSI (RJ-45)

- 4x 10 Гбит iSCSI или FCoE (SFP+, SW)

- 4x 16 Гбит FC (SFP+, SW или LW)

Стандартный функционал:

- виртуализация собственного дискового пространства (дисковые пулы)

- тонкое выделение ресурсов (Thin Provisioning)

- односторонняя миграция данных

- снапшоты (FlashCopy, до 64-х)

Опциональный функционал:

- удалённая репликация (Remote Mirroring)

- многоуровневое хранение данных (Easy Tier)

- увеличение максимального количества снапшотов (FlashCopy, расширение до 2048)

И так, перейдём к осмотру самого массива и из чего он состоит.

Мозгом и сердцем СХД является её контроллер. Он содержит процессор, который занимается обработкой всех вычислений, память, батарея, порты и тд. Как видно в нашем случае — память расширена до 16Gb и состоит из двух модулей по 8Gb.

FC порты в виде PCI-E HBA, но эта карта может быть заменена на iSCSI 1/10Gb или SAS. К сожалению не знаю — поддерживается ли самостоятельная замена HBA или это лишь облегчает конфигурирование массива перед покупкой. Под контроллерами находятся два Блока питания, мощностью 800W.

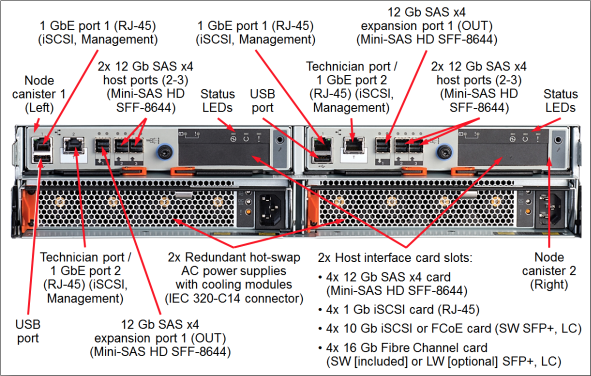

Не буду описывать все порты, у Lenovo в документации это прекрасно проиллюстрировано.

После того, как мы разобрали, что и для чего у нас в этом массиве есть, можно переходить к программной его части.

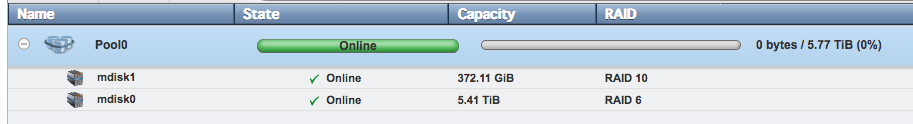

Собственно после настройки ip ардесов менеджмента и подключения массива к сети (О чём есть отличная инструкция в комплекте с массивом и сложностей на данном этапе возникнуть ни у кого не должно. Не сложнее чем подключить какой-нибудь домашний NAS) мы переходим к основному «слою», это mdisk`и (managed disk). Если объяснять по простому, то mdisk — это RAID группа, которые в дальнейшем объединяются в пулы и уже на них выделяются луны, которые презентуются хостам. Хостам не видны ни сами mdisk`и, ни пулы. mdisk`и могут быть организованы как из внутренних дисков массивов, так и из виртуализованных систем.

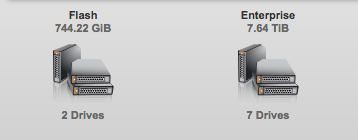

И так, у нас есть диски

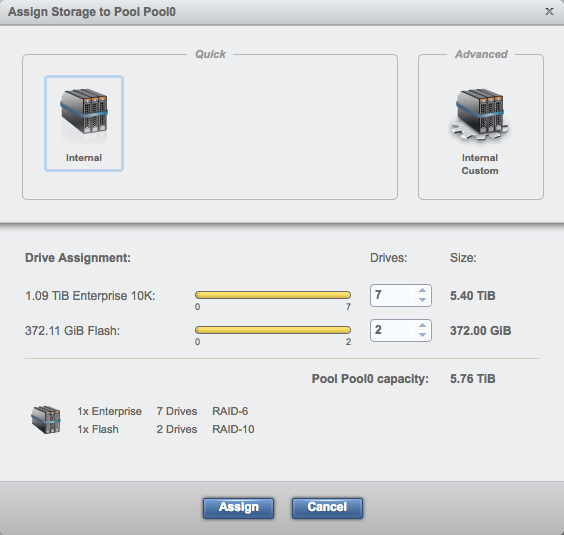

Мы добавляем оба типа диска в пул. При такой конфигурации SSD + HDD, в рамках этого пула у нас будет работать тиринг. Для работы тиринга так же необходима и лицензия Easy Tier. Он работает следующим образом:

- Встроенный механизм I/O Monitor следит за нагрузкой на на диск и при появлении «горячих» областей ввиду большого кол-ва обращений к этим данным, записывает статистику.

- Data Placement Advisor основываясь на 24-часовой статистики, распознаёт уровень нагрузки и передаёт данные о ней Data Migration Planner.

- Data Migration Planner анализирует полученные данные и имеющиеся физические ресурсов хранения и передаёт информацию Data Migrator.

- Data Migrator подтверждает и планирует перенос того или иного блока данных на более высокий или низкий уровень хранения, после чего выполняет миграцию данных.

- Работа Easy Tier проходит в фоновом режиме, и мы не имеем возможности следить за её работой на самом массиве.

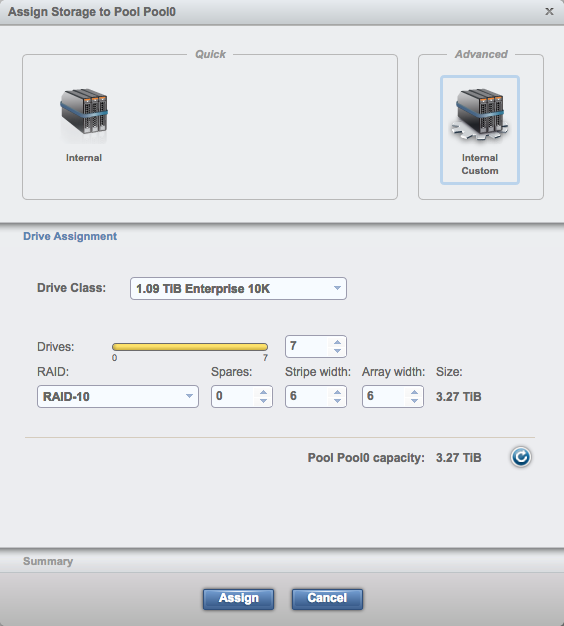

Мы можем собрать диски в пул как в автоматическом режиме, основываясь на рекомендациях массива

Так и сделать это полностью самостоятельно

Помимо классических RAID-1,5,6,10 поддерживаются так же Distributed RAID-5,6.

В итоге мы получаем пул, состояний из двух mdisk`ов, на котором в дальнейшем мы можем выделять ресурсы для наших нужд.

Чем мне всегда нравилась линейка Storwize, и собственно то, что не претерпело изменений у Lenovo — это простота данного массива. Если вы обладаете базовыми навыками и пониманием SAN и RAID — вы сможете сконфигурировать этот массив без особых сложностей. Бюджетные массивы других вендоров не дадут вам столь понятный и простой интерфейс. Но при этом не стоит забывать про CLI, который даёт массу возможностей как по настройке, так и мониторингу состояния.

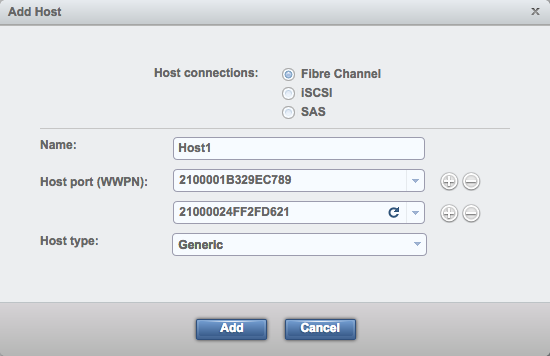

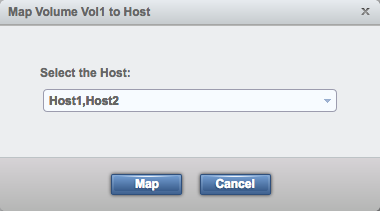

Но вернёмся к настройке. Теперь нам необходимо добавить наши серверы на массив, что бы им можно было презентовать созданные луны (предварительно нужно не забыть создать зонинг на san коммутаторах, в случае если у вас хосты подключаются не на прямую к СХД, об этом можно будет прочитать в 5-й части «Зонинг» моего цикла статей по Brocade SAN, которая скоро будет опубликована). Эта процедура так же очень проста, мы выбираем добавление хоста, выбираем wwn сервера (он их видит автоматически, хотя порой бывает что требуется перезагрузка хоста или переинициализация HBA сервера), указываем его имя и всё готово.

Так как у меня модификация массива XP — он поддерживает любой из типов подключения: FC, SAS, iSCSI. Я не буду затрагивать сильно тему того — что же лучше, FC или iSCSI. Конечно на данный момент времени iSCSI мало проигрывает по скорости, и при этом ещё даёт очень неплохую фору по стоимости оборудования.

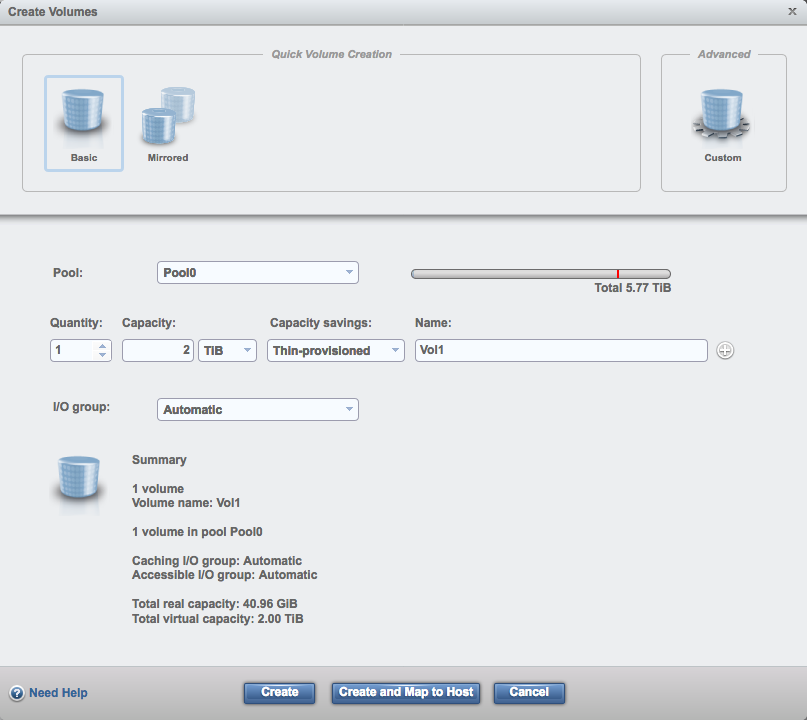

С созданием и презентацией лунов так же всё просто. Выбираем создание луна, выбираем обычный или зеркальный (но на мой взгляд — зеркальный при одном пуле дисков имеет не очень много логики), указываем количество, объём, толстый лун или тонкий, название, к какой i/o группе он относится.

После чего остаётся запустить процесс создания и отдать лун нашим серверам.

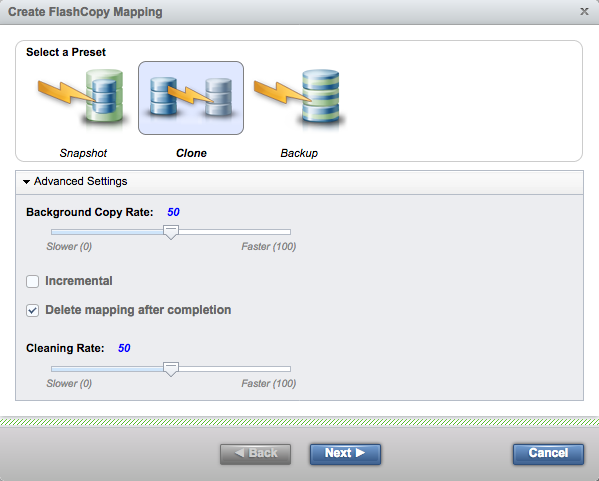

Всё это достаточно просто создаётся и настраивается, как я уже говорил, достаточно лишь понимать основы SAN. Теперь, когда у нас есть лун и мы отдали его нашим хостам, там возможно у нас уже есть какие то данные, с которыми мы можем работать на стороне массива, т.е. пришло врем рассмотреть поближе технологию FlashCopy. Эта фирменная технология позволяет вам создавать и управлять копиями ваших томов. По факту: Snapshot, Backup и Clone это просто несколько пресетов для работы системы FlashCopy.

- Snapshot — по сути это традиционный снапшот, то есть создается связь старого и нового тома, и все изменения пишутся уже на новый том.

- Clone — делает всё то же самое, что и Snapshot, но параллельно этому процессу идёт копирование «старых» данных со старого тома на новый. В итоге мы получаем полную копию тома на момент запуска клонирования + изменённые данные. При этом, после создания копии — связь между томами обрабывается и мы можем, к примеру, удалить старый том.

- Backup — и снова он делает всё то же самое что и предыдущий «пресет» Clone, но после окончания синхронизации связь не рвется, и целевой том всегда можно обновить изменёнными данными исходного тома.

Если открыть окно Create FlashCopy Mapping, то можно визуально увидеть что из себя представляют эти пресеты, для лучшего понимания.

Что касается мониторинга производительности, как и в большинстве СХД — только в реальном времени. Но мониторить вы можете лишь небольшое кол-во параметров. Это утилизация процессоров контроллеров, нагрузку на интерфейс, на луны и на mdisk`и. При чём в случае лунов и mdisk`ов — система показывает лишь их сумму. Вы не имеет возможности мониторить только отдельные части.

Но компания IBM предлагает для мониторинга массивов Storwize, а теперь и массивов Lenovo Storage V использовать IBM Tivoli Storage Productivity Center. Возможно для одного массива это будет слишком излишне, по этому за историю работы данной линейки массивов появилось большое кол-во сторонних приложений и систем для их мониторинга, к примеру, проект STOR2RRD.

Ну а что бы подробнее ознакомиться с возможностями Tivoli Storage Productivity Center, очень рекомендую вот этот вебинар.

В целом можно сказать что Lenovo Storage V3700 V2 XP, это достойное продолжение линейки Storwize. При чём именно расширенная — XP версия даёт большую производительность и гибкость конфигурации. Наверное для полного идеала, в качестве стартового массива ему не хватает файлового доступа, в дополнение к блочному. Если вы сталкивались с покупкой серверного оборудования, то скорее всего в курсе что на такие вещи как СХД — нет фиксированной цены. Есть list price, от которого вы получаете скидку, персональную для вашей компании, ввиду этого — говорить о стоимости массива просто не представляется возможным, т.к. скидка может варьироваться от 5 до 80%. Соответственно сложно сказать — оправдывает ли данный массив свою цену, или решения от конкурентов могу быть более выгодными. Тем более, что одним из основных показателей СХД — является именно производительность, которую сегодня мы не замеряли. В любом случае я рекомендую присмотреться к Lenovo V3700 V2 XP, это достойное продолжение линейки Storwize. Так же очень надеюсь, что данный материал поможет новичкам разобраться в нём.

«Думаю я не открою большого секрета, ведь многие это знают и так, компания Lenovo приобрела данную линейку массивов у компании IBM, как это произошло чуть ранее с серверным направлением.»

Только не всю линейку, а конкретный экземпляр железки в рамках OEM соглашения.

Вся разработка и производство — до сих пор в IBM, включая встраивание логотипа OEM партнера по заказу.

Александр, спасибо за уточнение!